Инженеры из компании Nvidia представили новый метод обучения ИИ на основе небольшого количества данных. Это позволит решать большой объем задач с помощью относительно слабых моделей.

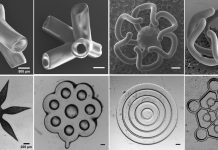

Компания NVIDIA разработала новый способ обучения генеративно-состязательной сети (GAN), которая в будущем может решать обширный объем задач. Исследователи объяснили, что каждая такая модель состоит из двух конкурирующих нейронных сетей: генератора и дискриминатора.

К примеру, если цель алгоритма — создание новых изображений, то сначала он исследует тысячи фотографий. Затем модель использует эти данные для тренировки своего контрагента. Для создания стабильно достоверных результатов традиционным GAN необходимо 50-100 тысяч тренировочных изображений. Если их слишком мало, то новые изображения будут недостоверными или некачественными.

Инженеры NVIDIA же решили специально искажать часть изображений, чтобы модель училась понимать вариации. При этом они делают это не на протяжении всей тренировки, а выборочно, чтобы модель избежала перегрузки.

Такой искусственный интеллект легко можно обучить навыкам написания нового текстового материала, потому что он может понять принципы работы на основе маленькой выборки. Однако исследователи отмечают, что обучить алгоритм распознавать редкое неврологическое расстройство мозга будет сложно именно из-за его редкости. Исследователи надеются обойти эту проблему в будущем.

Хотите больше узнать про ИИ? Пожалуйста! искусственный интеллект Spotify с лёгкостью найдёт плагиат в песнях.

В качестве бонуса врачи и исследователи могут делиться своими результатами, так как алгоритм работает на основе сгенерированных изображений, а не реальных данных пациентов. Подробнее о новом подходе обучения NVIDIA расскажет на предстоящей конференции NeurIPS, которая состоится 6 декабря.

Источник: искусственный интеллект с сайта hightech.fm